19. 总结

总结

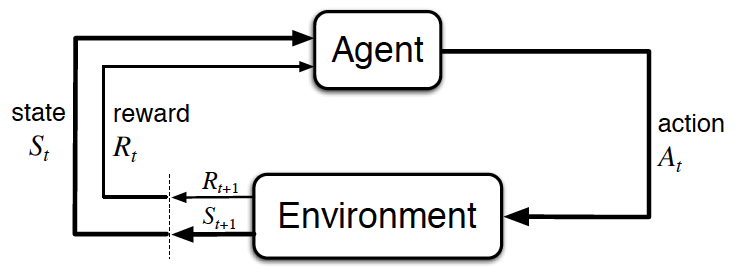

强化学习中的智能体环境互动。(来源:Sutton 和 Barto,2017 年)

设置,重新经历

- 强化学习 (RL) 框架包含学习与其环境互动的智能体。

- 在每个时间步,智能体都收到环境的状态(环境向智能体呈现一种情况),智能体必须选择相应的响应动作。一个时间步后,智能体获得一个奖励(环境表示智能体是否对该状态做出了正确的响应)和新的状态。

- 所有智能体的目标都是最大化预期累积奖励,或在所有时间步获得的预期奖励之和。

阶段性任务与连续性任务

任务是一种强化学习问题。

连续性任务是一直持续下去、没有结束点的任务。

阶段性任务是起始点和结束点明确的任务。

- 在这种情况下,我们将一个完整的互动系列(从开始到结束)称为一个阶段。

- 每当智能体抵达最终状态,阶段性任务都会结束。

奖励假设

- 奖励假设:所有目标都可以构建为最大化(预期)累积奖励。

目标和奖励

- (请参阅第 1 部分和第 2 部分,以查看在现实问题中如何指定奖励信号的示例。)

累积奖励

- 在时间步 t 的回报是 G_t := R_{t+1} + R_{t+2} + R_{t+3} + \ldots

- 智能体选择动作的目标是最大化预期(折扣)回报。(注意:折扣将在下部分讲解。)

折扣回报

- 在时间步 t 的折扣回报是 G_t := R_{t+1} + \gamma R_{t+2} + \gamma^2 R_{t+3} + \ldots 。

- 折扣回报 \gamma 是你设置的值,以便进一步优化智能体的目标。

- 它必须指定 0 \leq \gamma \leq 1。

- 如果 \gamma=0,智能体只关心最即时的奖励。

- 如果 \gamma=1,回报没有折扣。

- \gamma 的值越大,智能体越关心遥远的未来。\gamma 的值越小,折扣程度越大,在最极端的情况下,智能体只关心最即时的奖励。

MDPs和一步动态特性

- 状态空间\mathcal{S}是所有(非终止)状态的集合。

- 在阶段性任务中,我们使用\mathcal{S}^+表示所有状态集合,包括终止状态。

- 动作空间 \mathcal{A}是潜在动作的集合。 (此外, \mathcal{A}(s)是指在状态s \in \mathcal{S}的潜在动作集合。)

- (请参阅第 2 部分,了解如何在回收机器人示例中指定奖励信号。)

- 环境的一步动态特性会判断环境在每个时间步如何决定状态和奖励。可以通过指定每个潜在 s', r, s, \text{and } a 的 p(s',r|s,a) \doteq \mathbb{P}(S_{t+1}=s', R_{t+1}=r|S_{t} = s, A_{t}=a) 定义动态特性。

- 一个(有限)马尔可夫决策过程 (MDP) 由以下各项定义:

- 一组(有限的)状态 \mathcal{S}(对于阶段性任务,则是 \mathcal{S}^+)

- 一组(有限的)动作 \mathcal{A}

- 一组奖励 \mathcal{R}

- 环境的一步动态特性

- 折扣率 \gamma \in [0,1]